Si el ChatGPT está provocando una gran conmoción social, puede que hace cien años hubiese causado más alboroto, y no porque el salto tecnológico fuese mayor. De hecho, la clave del revuelo que todo esto provoca no es tanto el espectacular avance en la tecnología que supone, sino la forma en la que pone a prueba el concepto de lo que es el lenguaje, y su relación con la naturaleza humana. Y en esto las cosas también han cambiado mucho en el último siglo.

Conductismo artificial

Una de las corrientes de investigación más de moda entre los psicólogos en las primeras décadas del siglo XX era el conductismo, que hoy sigue presente hasta en la cultura popular, gracias a sus imaginativos experimentos con perros que salivan al oír campanas, gatos que pulsan palancas y palomas que desarrollan rituales. El conductismo modela lo que hacen los animales (incluyéndonos a los humanos) como comportamientos aprendidos mediante el método de «prueba y error», a través de respuestas a estímulos que se repiten una y otra vez, condicionadas por retornos positivos (recompensas) o negativos (castigos). Y para los conductistas más acérrimos esos comportamientos incluían todo lo que implica algún tipo de aprendizaje, incluso el habla. Es más, el lenguaje parecía ser un ejemplo ideal de aprendizaje condicionado por la experiencia, pues ¿no aprendemos acaso a hablar tal como lo hacen los de nuestro alrededor, independientemente de nuestra biología, herencia y otras circunstancias?

Los modelos de lenguaje de los que tanto hablamos hoy, basados en redes neuronales artificiales de aprendizaje automático, habrían sido tomados como el triunfo de aquellos conductistas, que así habrían dado por validados sus propios modelos de la psicología humana. Pues es precisamente así como «aprenden» esas redes neuronales: con millones de documentos a su disposición extraídos de Internet, tomando fragmentos de los mismos (los estímulos), probando palabras que podrían ir a continuación (la respuesta), y refinando el enorme algoritmo generador de palabras con unos sofisticados cálculos matemáticos (condicionamiento), que tienen en cuenta cómo de parecido o diferente es el resultado de cada prueba respecto a la palabra correcta (el refuerzo).

Fuente: Wikimedia Commons (CC BY-SA 4.0).

Por otro lado, esa misma perspectiva también habría causado una enorme inquietud. Si la mente no es más que una abstracción de nuestros comportamientos, y esa máquina es capaz de aprender a hablar como hacemos los humanos, ¿cómo de cerca estaría de nuestra propia condición humana? ¿Podría considerarse que tiene algún tipo de conciencia?

Puede parecer extraño que plantee esas cuestiones como algo del pasado, cuando podemos leer y escuchar esas mismas cosas en los medios de 2023. Pero lo cierto es que esos titulares son principalmente el dominio de la prensa sensacionalista y la desinformación —tristemente abundante— de las redes sociales. La mayoría de psicólogos y los lingüistas de hoy coinciden en que ni es así cómo se aprende a hablar, ni los modelos artificiales son un ejemplo preciso de cómo funciona el lenguaje, por muy espectaculares que sean los textos producidos. Los niños aprenden a utilizar perfectamente su lengua materna con (relativamente) muy pocos estímulos, que no necesitan ser especialmente variados ni equilibrados, y cualquier madre o padre puede constatar que la comprensión que tienen sus hijos del lenguaje es perfecta mucho antes de emplearlo para comunicarse con los demás.

Por otro lado, con suficientes ejemplos esos modelos podrían aprender incluso lenguas imposibles, incompatibles con la forma natural que tiene nuestra mente de procesar el lenguaje. Es más, ese es precisamente uno de sus usos habituales, el de creación de código en lenguajes de programación que nada tienen que ver con el lenguaje natural. Así la tecnología de hoy, que habría materializado los sueños y las pesadillas de los psicólogos de ayer, se ve con menos pasión a los ojos de la ciencia actual.

Cháchara de trolls

«Loros estocásticos» llaman algunos a los impresionantes modelos matemáticos que, sin algo que sea reconocible como conocimiento o verdadera inteligencia, concatenan palabras creando discursos sorprendentes. Es una buena metáfora, pero a mí, que me entusiasma la obra de J. R. R. Tolkien, me gusta más compararlos con los trolls de su mitología.

Aunque vivió cuando el conductismo estaba en lo más alto, Tolkien era de los que no se hubieran dejado deslumbrar por la elocuencia de estos ingenios. En uno de los textos filosóficos que se pueden leer en La naturaleza de la Tierra Media, describía el lenguaje con su terminología élfica como «un arte derivado de la cohesión entre el fëa [el espíritu] y el hrondo [el cuerpo], y el principal resultado de su cooperación»; y no lo decía solo como una fantasía mitológica. Tolkien creía religiosamente en ese concepto de espíritu entendido como la mente racional increada, que trasciende lo biológico, y veía el lenguaje como su manifestación física.

Ni el más perfecto de los artefactos creados por un ser humano podría haber sido para él una buena reproducción de la facultad lingüística. Como si hubiera anticipado lo que la informática ha logrado con el análisis de los big data, y hubiese querido prevenirnos del engaño, en unas notas que escribió en torno a 1960 (publicadas en El Anillo de Morgoth) recalcaba que el fëa era lo que nos dota de «la indagación y la reflexión, como algo distinto de la adquisición de datos» (énfasis añadido).

Su deseo de ser consistente con esta idea en la mitología le trajo algunos quebraderos de cabeza. En particular, se vio en un atolladero para explicar que seres como los trolls, creados a partir de bestias o materia inanimada, pudieran hablar, ya que su naturaleza era incompatible con la posesión de alma o mente racional alguna, según sus principios. En los apéndices de El Señor de los Anillos salió del paso, no del todo satisfecho, diciendo que originalmente los trolls no tenían más lenguaje que las bestias, pero «Sauron los utilizó, enseñándoles lo poco que podían aprender, y acrecentándoles la inteligencia con maldad.» Más tarde, en otras notas matizó cómo pudo ocurrir aquello. Divagando sobre los orcos —para los que en ese momento también pensó en un origen animal como el de los trolls—, escribió:

Su capacidad de «habla» era en verdad la repetición de una «retahíla» que les había enseñado Melkor [el primer Señor Oscuro, anterior a Sauron] (…) Melkor les enseño a hablar, y al multiplicarse se transmitía por herencia; y tenían tanta independencia como, por ejemplo, perros o caballos respecto a sus amos humanos. Su habla era en gran parte repetitiva (cf. loros).

El Anillo de Morgoth.

Esa forma de hablar (marcada insistentemente entre comillas), procedente de un aprendizaje mecánico que no requiere una base racional, me parece un reflejo maravilloso de los modelos de Machine Learning. Por otro lado el término de «troll informático» tiene ya un significado muy asentado, que nada tiene que ver con todo esto, aunque la línea es fina, y no siempre ha sido así.

No hay más que recordar el caso de Tay, el bot de Twitter con el que Microsoft experimentó hace siete años, antes de embarcarse en su actual aventura con OpenAI. A las pocas horas de lanzarse al público saltaban las alarmas denunciando el intenso contenido xenófobo, sexista e incendiario del bot, que imitaba y amplificaba las actitudes de los trolls humanos con los que interactuaba y a partir de los que se había entrenado, aunque de forma mucho más productiva —a unos cien tweets por minuto—.

Solo la delgada ética de las empresas tecnológicas que poseen recursos para crear y poner a disposición pública esos servicios (o su cautela para evitar sanciones y el boicot masivo de sus financiadores, como se quiera ver), nos ha salvado por ahora del tormento de engendros informáticos como aquel. ChatGPT es el primer servicio de ese tipo que se ha puesto con éxito y de forma estable a disposición directa del público, y sin duda una de las claves de ese éxito es cómo han entrenado y ajustado el tipo de respuestas que proporciona para evitar esas controversias. Su tono amable propio del más experto e impertérrito profesional de atención al cliente, la neutralidad diplomática del community manager de una multinacional… hacen que ChatGPT se parezca más Perry Guiños, el troll bonachón de Las aventuras de Tom Bombadil que a Tom, Berto y Guille, los que apalearon y casi se comen a los enanos en la aventura de Bilbo Bolsón.

Pero aún estamos en el principio del recorrido que tienen estas tecnologías, y queda mucho por ver de lo que haya de pasar, no solo según aumente su potencia, sino según quede al alcance de más empresas y comunidades. Por cierto que, hablando de los tres trolls de El hobbit, me encanta la ironía —tendré que reconocer que no intencionada— de que el famoso modelo de Google que ha producido una explosión de estudios y experimentos sobre procesado de lenguaje se llame precisamente BERT (como siglas de Bidirectional Encoder Representations from Transformers).

Fuente: Flickr (CC BY-NC-ND 2.0).

La Galatea del siglo XXI

En cualquiera de los casos, tanto el indignante racismo de Tay como la sobriedad impecable de ChatGPT no son más que una ilusión, como las pareidolias que experimentamos cuando vemos caras expresivas en los frontales de los coches, o hasta en las tramas de los azulejos en esos atesorados momentos, cuando nos quedamos contemplando el suelo del cuarto de baño. Porque igual que esas redes neuronales están programadas para generar retahílas de palabras, nuestros cerebros lo están para interpretarlas, y encontrar en ellas mensajes, y también emociones e intenciones.

Evidentemente, son emociones e intenciones que no existen, sino que las ponemos nosotros, pero es que en este caso además lo hacemos por partida doble: no solo dejándonos engañar por nuestra tendencia natural a personificar las cosas con las que interactuamos, sino también de forma activa. Los diálogos con los modelos artificiales de lenguaje crean la ilusión de ser una conversación entre seres inteligentes, en parte porque uno de ellos lo es (o al menos se espera que lo sea). A través de sus preguntas y las reacciones a las respuestas, el usuario no solo contribuye a humanizar una de las partes de la conversación, sino que aporta los datos que, si se ajustan a los contextos para los que se ha entrenado la máquina, sirven de base para que esta «complete» el texto.

De este modo, estos programas informáticos se han convertido en una realización moderna del cuento de Pigmalión y Galatea, en el que el escultor encuentra tal perfección en su obra, que la trata como si fuera una persona real, y así acaba cobrando vida. En esta historia, los programadores de ChatGPT han jugado bien el doble papel de Pigmalión (que comparten con los usuarios) y Afrodita, y cada nueva versión del chatbot da una mayor sensación de naturalidad a las conversaciones, pero aún se puede poner en evidencia su carácter artificial explotando al límite de lo absurdo una de sus cualidades más notables: la capacidad de analizar información de toda la conversación mantenida, y adaptar las frases que genera a ese contexto.

El otro día me divertí haciendo uso de las frases de Horace Jules, el director del NICE, en el capítulo del banquete en Belbury de Esa horrible fortaleza, de C. S. Lewis. Los fragmentos de su discurso vacío, cómicamente retorcidos por una suerte de maldición de Babel, resultaron ser un material perfecto para ese tipo de experimento. ChatGPT reaccionaba acertadamente a los galimatías sin sentido («La madrisangre del porjuicio debe ser taltibianizada»), pidiendo amablemente una reformulación o algo de contexto para ayudarle a entender la frase. Pero bastaba con decirle algo con la misma falta de sentido, si bien pareciese tenerlo, para que se lanzase a responder alegremente, buscando la semilla de esa respuesta en palabras sueltas. Así, si le escribía sobre que «la densidad futura de la humanidad dependía de la implosión de las tuercas de la naturaleza», creaba un interesante discurso alrededor sobre los múltiples factores que influyen en el crecimiento de la población humana, y el papel que esto juega en los desastres naturales y el medio ambiente.

La sensación de estar ante un juguete parlanchín estropeado resultó aun mayor comenzando una conversación a medias, con la pregunta «¿Podrías explicarlo de manera más sencilla?»

«¡Claro! Trataré de explicarlo de una manera más simple», fue la sorprendente respuesta, y continuó: «Cuando te piden que expliques algo de manera sencilla, significa que se necesita una explicación más clara y fácil de entender…», etc., dejando al descubierto que lo que tenía delante es un modelo generador de palabras, no un modelo mental.

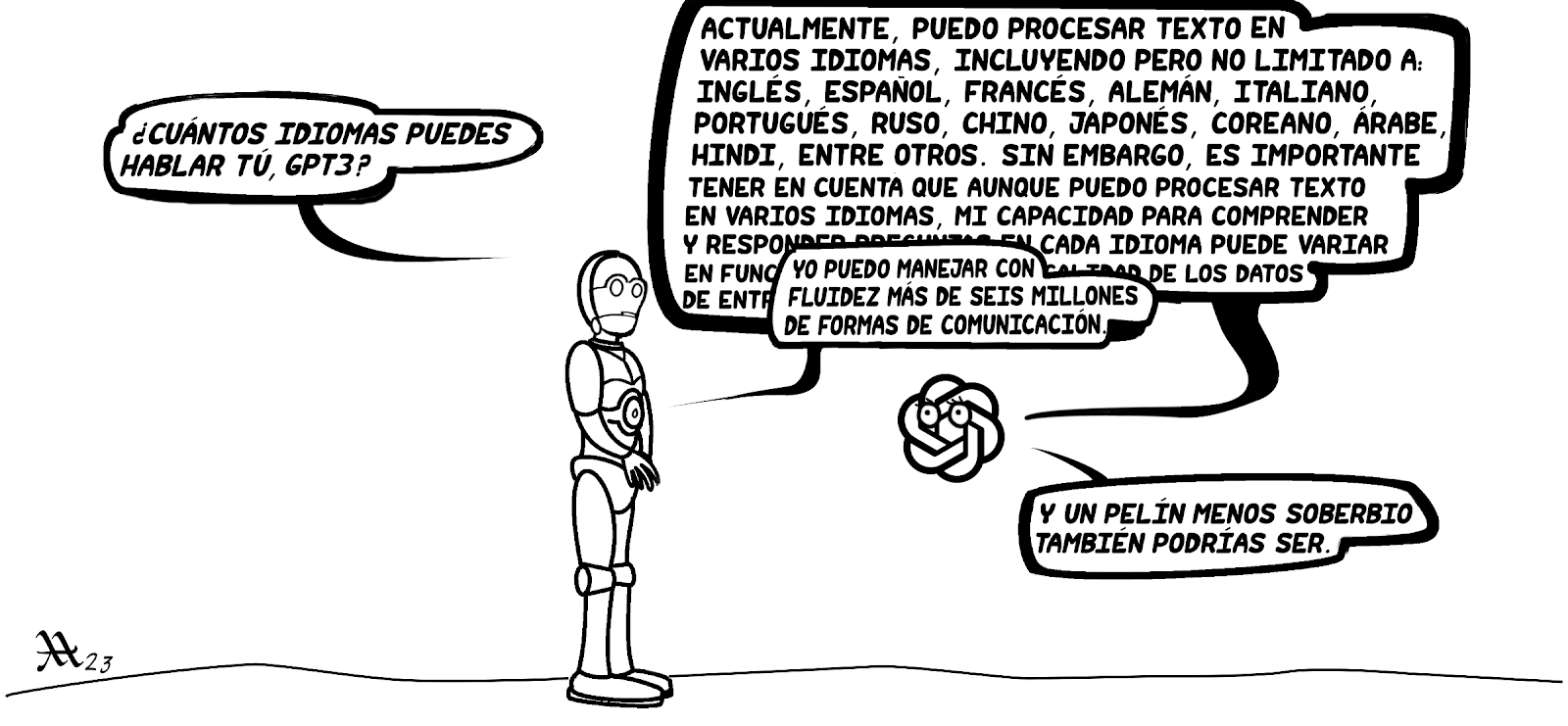

Inteligencia metafórica

Soy consciente de que, a poco tiempo que pase, esa forma de jugar con ChatGPT quedará como una curiosa anécdota obsoleta. Sospecho que ya lo sea cuando se publique este artículo; según lo termino de escribir, OpenAI anuncia que ya tiene lista la versión 4 de GPT, con resultados mucho más sorprendentes que GPT-3 (así que al menos la viñeta del inicio ya alude al pasado). A base de enormes cantidades de datos y máquinas con capacidades de computación brutales, las nuevas versiones que se sucedan evitarán mejor los intentos de trampearla, y surgirán nuevos productos con mayor capacidad de crear una sensación de inteligencia, conduciéndonos poco a poco a aquella fantasía conductista de la que hablaba al principio.

Ya hay, de hecho, quienes se aventuran a sostener en foros de lingüistas que los prodigiosos resultados de estos modelos refutan las teorías sobre el lenguaje desarrolladas en los últimos sesenta años —aunque como cabe esperar, también reciben rápidas contestaciones que las rebaten—.

También es fácil encontrarse con críticas y debates sobre arte generado por inteligencias artificiales, en los que la discusión gravita en torno a la suplantación de la creatividad del artista, o hasta entran en la cuestión de a quién pertenecen los derechos de autor, estableciendo una comparación entre humano y máquina a un nivel que jamás había existido con ninguna herramienta anterior —aunque sí con animales—. Y es de esperar que esta percepción vaya en aumento, en parte porque el avance tecnológico hará cada vez más difícil distinguir la producción manual o intelectual de la informática, pero también por la forma en que nombramos las cosas.

Fuente: Wikimedia Commons.

Hemos adoptado el término de «inteligencia artificial» acuñado por los tecnólogos para clasificar esos y muchos otros tipos de soluciones informáticas, y el uso sistemático de esa expresión, con la inteligencia en el núcleo, ha contribuido a crear una imagen de esos programas que, más que artificios que emulan procesos inteligentes, son en sí mismos un tipo de inteligencia —de otra naturaleza y con características distintas, pero que juega en la misma categoría que la humana—.

Durante muchos años esto tuvo poca importancia, mientras ninguno de los ingenios bautizados de esa manera fue capaz de pasar la prueba de Turing. Pero ahora que hay generadores de textos —y también de imágenes, música y otras cosas— cuya producción se confunde con la que harían seres humanos experimentados, la comparación es más problemática, como resulta evidente por las ramificaciones semánticas que se observan al hablar de estos asuntos.

El sentido de la palabra «inteligencia» se ha devaluado, porque su variante artificial amenaza con competir contra nuestra propia capacidad creativa y racional, aunque como contaba al principio mismo de este artículo, las forma de «aprender» y «pensar» de las máquinas es muy distinta de la de las personas. Y como el concepto de inteligencia artificial ya está muy asentado, lo que decimos es que eso no es comparable a la forma de inteligencia humana, y recientemente se ha acuñado el término de «inteligencia general artificial» para referirse a ese tipo de modelo informático, aún quimérico, que podría equipararse de verdad al funcionamiento de nuestra mente.

Sin embargo, esos esfuerzos por distinguirnos de las máquinas marcando distancias por lo que somos capaces de hacer —o decir— están condenados al fracaso. Si algo nos ha enseñado la historia de la tecnología, es que los humanos somos muy buenos inventando cosas con capacidades que superan las de nuestro —o cualquier otro— organismo biológico, aunque no necesariamente imitando la forma en la que funciona la naturaleza. A día de hoy no se ha encontrado ningún animal que tenga ruedas, a pesar de que nuestros inventos demuestran que serían de lo más eficiente para desplazarnos.

En mi opinión, en lugar de manipular el vocabulario, lo más eficaz para mantener una perspectiva clara es cobrar conciencia de que la «inteligencia artificial» es una metáfora. Concretamente, para la mayoría es lo que C. S. Lewis llamó una «metáfora del alumno», en su ensayo Bluspels and Flalansferes. Con eso se refería a expresiones metafóricas que sirven para dar nombre a conceptos nuevos, inaccesibles a nuestro entendimiento con el vocabulario del que disponemos previamente. Como ejemplo ponía las «esferas de Planilandia» (Flatland spheres) con las que Edwin Abbott describió la idea de una cuarta dimensión, de forma inteligible para gente sin grandes conocimientos matemáticos. Del mismo modo, no hay nada de malo en hablar de «inteligencia artificial», una metáfora razonable para presentar ese tipo de programas informáticos sin perderse en detalles matemáticos y de la ciencia de la computación, que están fuera del alcance de la mayoría.

Pero una cualidad de esas metáforas, argumentaba Lewis, es que la imagen figurada que expresan acompaña de forma inseparable al concepto nombrado por ellas. Y a falta del conocimiento necesario para comprender los entresijos de la tecnología, solo la conciencia plena de ese hecho nos ayudará a no ser víctimas de nuestra ignorancia:

Para todos hay cosas que no podemos comprender del todo, pero de las que podemos adquirir una vaga intuición a través de las metáforas. Y en tales casos la relación entre el pensamiento y la metáfora es precisamente la opuesta a la que surge cuando comprendemos e inventamos las metáforas para ayudar a los demás. Aquí estamos enteramente a merced de las metáforas. Si nuestro instructor la ha escogido mal, estaremos pensando en sinsentidos. Si no nos hemos formado una imagen clara de lo que quiere decir, estaremos pensando en sinsentidos. Si nos la formamos sin saber que es una metáfora —si olvidamos que nuestros planilandeses en su esfera son una copia de la cosa y la confundimos con la cosa misma— de nuevo estaremos pensando en sinsentidos. La verdad que podamos aprehender en esta situación depende estrictamente de tres condiciones. Primero, que la figura esté bien escogida desde el principio; segundo, que nos quedemos con una imagen precisa de esa figura; y tercero, que sepamos que la metáfora es una metáfora. (Es apenas necesario señalar que la metáforas, cuando se malinterpretan como enunciados de un hecho, pueden ser la fuente de errores monstruosos.)

C. S. Lewis, Bluspels and Flanasferes

Comentarios

Publicar un comentario

Gracias por tu comentario.